引言

在机器学习领域,迁移学习已成为提升模型训练效率和性能的重要策略,特别是在标注数据稀缺的场景下。Transformer模型自2017年由Google提出以来,在自然语言处理(NLP)领域取得了突破性进展,并逐渐扩展到计算机视觉(CV)等多个领域。本文旨在深入探讨基于Transformer的迁移学习,从理论与实践两个维度分析其原理、优势及具体实现方法,并结合实际案例和代码示例,展示其在不同场景下的应用。

Transformer在机器学习领域的应用

原理与优势

Transformer是一种基于自注意力机制的深度学习模型,专门设计用于处理序列数据。其核心组件包括编码器(Encoder)和解码器(Decoder),每个部分由多个自注意力层和前馈神经网络层组成。相较于传统的循环神经网络(RNNs)和长短期记忆网络(LSTMs),Transformer通过完全去除循环结构,实现了高度的并行化,极大地加速了模型训练速度和推理效率。此外,自注意力机制使Transformer能够捕捉输入序列中各元素间的复杂依赖关系,无论这些元素在序列中的距离远近,这对于理解长文本尤为关键。

迁移学习

迁移学习,作为机器学习领域的一个重要分支,专注于利用在一个或多个源任务上学到的知识,来帮助提升在目标任务上的学习效果。这种学习方法的核心在于,它允许模型将从一个环境或任务中学到的经验和表示,迁移到另一个不同但相关的环境或任务中。

迁移学习的关键优势在于其能够显著降低对大量标注数据的依赖。在许多实际应用场景中,标注数据往往是稀缺且昂贵的,而迁移学习通过利用已有的、相关的标注或未标注数据,可以有效地减轻这一负担。此外,迁移学习还能够加速模型的训练过程,提高模型的泛化能力,使其更好地适应新的、未见过的数据。

迁移学习的方法多种多样,包括但不限于基于实例的迁移、基于特征的迁移、基于参数的迁移以及基于关系的迁移等。这些方法可以根据具体的应用场景和需求进行选择和优化,以实现最佳的迁移效果。

实现迁移学习

Transformer是一种基于自注意力机制的深度学习模型,专门设计用于处理序列数据。其核心组件包括编码器(Encoder)和解码器(Decoder),每个部分由多个自注意力层和前馈神经网络层组成。相较于传统的循环神经网络(RNNs)和长短期记忆网络(LSTMs),Transformer通过完全去除循环结构,实现了高度的并行化,极大地加速了模型训练速度和推理效率。此外,自注意力机制使Transformer能够捕捉输入序列中各元素间的复杂依赖关系,无论这些元素在序列中的距离远近,这对于理解长文本尤为关键。

实践技巧与方法

实际案例:基于BERT的文本分类

BERT(Bidirectional Encoder Representations from Transformers)是Transformer的一个重要变体,通过大规模预训练在自然语言处理任务中表现出色。以下是一个基于BERT进行文本分类的实践案例:

- 数据准备:准备用于文本分类的标注数据集,包括训练集和测试集。

- 模型加载与微调:

- 加载预训练的BERT模型。

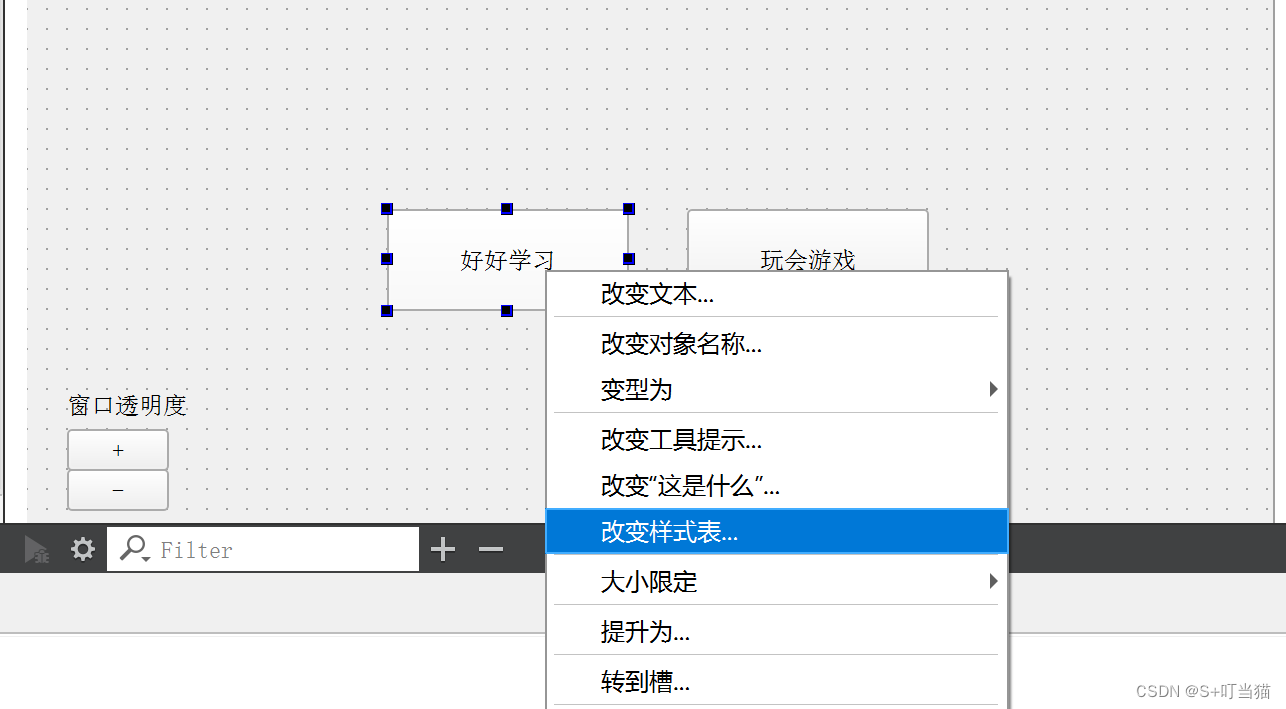

- 根据分类任务的需求,修改BERT模型顶部的全连接层,以适应分类任务的类别数。

- 在训练集上对修改后的模型进行微调,通过反向传播优化模型参数。

- 评估与调优:在测试集上评估模型性能,根据需要进行参数调优或超参数搜索。

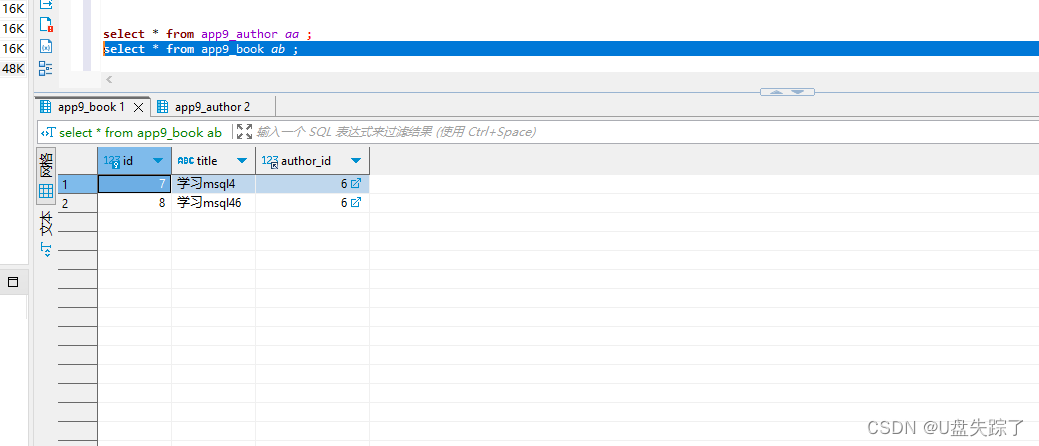

代码示例

以下是一个简化的PyTorch代码示例,展示如何加载BERT模型并进行微调:

import torch

from transformers import BertTokenizer, BertForSequenceClassification

from torch.utils.data import DataLoader, TensorDataset

# 假设已有预处理好的数据:inputs_ids, attention_masks, labels

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=2) # 假设是二分类任务

# 创建DataLoader

dataset = TensorDataset(torch.tensor(inputs_ids), torch.tensor(attention_masks), torch.tensor(labels))

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

# 定义优化器和损失函数

optimizer = torch.optim.AdamW(model.parameters(), lr=5e-5)

loss_fn = torch.nn.CrossEntropyLoss()

# 训练模型

model.train()

for epoch in range(num_epochs):

for batch in dataloader:

inputs, masks, labels = batch

optimizer.zero_grad()

outputs = model(inputs, attention_mask=masks, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

# ...(评估模型等后续步骤)代码示例:基于ViT的图像分类

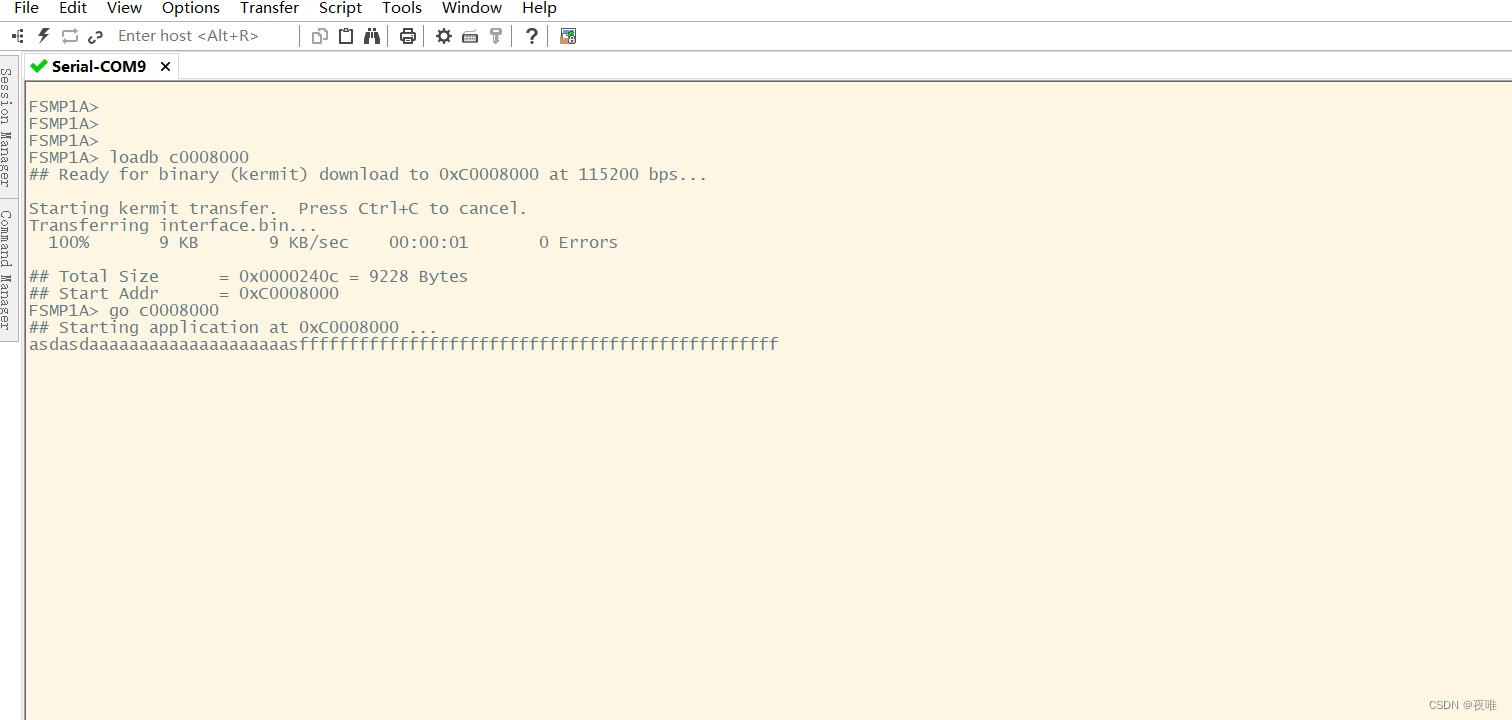

以下是一个使用PyTorch和timm库(一个流行的PyTorch图像模型库)来实现基于ViT的图像分类的代码示例:

import torch

from timm.models import vision_transformer

from torch.utils.data import DataLoader

from torchvision import datasets, transforms

# 数据准备和预处理

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

])

dataset = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

dataloader = DataLoader(dataset, batch_size=64, shuffle=True)

# 加载预训练的ViT模型

model = vision_transformer('vit_base_patch16_224', pretrained=True, num_classes=10) # CIFAR-10有10个类别

# 定义优化器和损失函数

optimizer = torch.optim.AdamW(model.parameters(), lr=5e-4)

loss_fn = torch.nn.CrossEntropyLoss()

# 训练模型

model.train()

for epoch in range(num_epochs):

for batch in dataloader:

images, labels = batch

optimizer.zero_grad()

outputs = model(images)

loss = loss_fn(outputs, labels)

loss.backward()

optimizer.step()

# ...(评估模型等后续步骤)在这个例子中,我们首先准备了CIFAR-10数据集,并对图像进行了必要的预处理。然后,我们加载了一个预训练的ViT模型,并修改了其顶部的全连接层以适应CIFAR-10的10个类别。接着,我们定义了优化器和损失函数,并开始训练模型。

- 数据预处理是深度学习流程中至关重要的一步,它直接影响到模型的训练效果和泛化能力。

结论

本文深入探讨了基于Transformer的迁移学习,从模型原理、优势到具体实践技巧和方法进行了全面介绍。通过实际案例和代码示例,展示了如何在文本分类等任务中应用BERT等预训练模型进行迁移学习。Transformer及其变体以其强大的序列建模能力、高效的并行计算和对长距离依赖的有效捕捉,在自然语言处理及其他领域展现了广泛的应用前景。随着研究的深入,基于Transformer的迁移学习将继续推动机器学习技术的发展,为更多实际应用场景提供有力支持。